Stable Diffusionとは- 新世代AI画像生成技術を徹底解説

Stable Diffusionとは、テキストから写真のようにリアルな画像を生成することができるAI技術です。この技術は、2022年にドイツのLMUミュンヘン大学の研究者によって開発され、オープンソースとして公開されました。Stable Diffusionは、画像生成の分野で画期的な成果をもたらし、多くの人々の注目を集めています。

本記事では、Stable Diffusionの基礎知識から応用方法までをわかりやすく解説します。まず、Stable Diffusionの仕組みや特徴について説明します。次に、Stable DiffusionをWebブラウザ上で利用できるサービスとして紹介します。Hugging FaceやGithubなどのプラットフォームを使って、Stable Diffusionを自由に試すことができます。また、Stable Diffusionを使って画像生成する際に必要なプロンプトの作成方法やポイントについても解説します。さらに、Stable Diffusionを使ってできることや注意点についても紹介します。最後に、Stable Diffusion以外の画像生成AIについても触れます。

本記事を読めば、Stable Diffusionの魅力や可能性を感じることができるでしょう。ぜひ、Stable Diffusionを使って自分だけの画像を生成してみてください。

目次

- はじめに

- Stable Diffusionとは?

- Stable Diffusionの技術的背景

- Stable Diffusionの主な利用方法

- Webブラウザ上で利用できるStable Diffusionのサービス

- Hugging Faceの使い方

- Githubの使い方

- Stable Diffusionのプロンプト作成と作成時のポイント

- Stable Diffusionのプロンプト例

- Stable Diffusionを使ってできること

- Stable Diffusionを構築するための参考資料

- Stable Diffusion利用時の注意点

- Stable Diffusion以外の画像生成AI

- まとめ

はじめに

人工知能(AI)の進化は、様々な産業を変革しています。その中でも画像生成技術は特に注目を集めており、新たなビジュアル体験を生み出す可能性を秘めています。本文書では、その一つであるStable Diffusionという技術について解説します。Stable Diffusionの特性、利用方法、その他の関連情報を詳しく説明し、この技術を利用する際の注意点やヒントを提供します。

Stable Diffusionとは?

Stable DiffusionはAI技術の一部門であり、特に画像生成の分野で利用されます。通常、この技術はGANs(Generative Adversarial Networks)というフレームワークを活用して実装され、多種多様な画像を生成する能力を持つAIモデルを作成することが可能です。

Stable Diffusionは拡張機能を有しており、ユーザーのニーズに応じてさまざまな機能を追加することができます。これには、特定の種類の画像生成ツールや、AIとの対話を円滑に進行させるためのインターフェースなどが含まれます。

Low-Rank Adaptation(LoRA)は、既存のAIモデルを特定のタスクやデータセットに対して最適化するための手法です。この手法は、モデルのパラメーターの一部に対する低ランクの制約を使用することで、新しいタスクに対してモデルを迅速に適応させることを可能にします。

具体的には、LoRAは基礎モデルに対して新しい学習データを適用させてモデルを調整する技術です。ここでの"低ランク"とは、モデルの重み行列が持つ特性を指し、モデルのパラメータ数を大幅に削減し、効率的な学習を可能にします。

したがって、Stable DiffusionとLoRAを組み合わせて使用すると、AIが生成する画像の質や種類を特定のデータセットに適応させ、さらに自身のニーズに合わせてカスタマイズすることが可能になります。

ただし、この技術は一部の高度なユースケースに適用され、日本語や商用利用、拡張機能といった要素とは別に理解し、適用する必要があります。

最後に、Stable Diffusionやその他のAIツールは多くの場合、英語でのインターフェースが一般的ですが、日本語に対応したツールも存在します。具体的には、日本語のプロンプトを理解する能力や、日本語でのインターフェースを提供するツールがあるかどうかを確認する必要があります。

Stable Diffusionの技術的背景

Stable Diffusionは、GANs(Generative Adversarial Networks)というフレームワークを活用したAI技術の一部門です。GANsは、機械学習モデルを訓練するためのフレームワークで、画像生成に特に強いとされています。GANsは生成器と識別器の2つのネットワークが相互に競争することでモデルを訓練します。

Stable Diffusionは、元のデータ分布を表現する確率モデルを使用し、その確率モデルからランダムにサンプルを生成します。通常、Stable Diffusionは高次元データ(例えば、画像)の生成に用いられます。

さらに、Stable DiffusionはLow-Rank Adaptation(LoRA)という手法を組み合わせることで、既存のAIモデルを特定のタスクやデータセットに対して最適化することが可能です。LoRAは、モデルのパラメーターの一部に対する低ランクの制約を使用することで、新しいタスクに対してモデルを迅速に適応させることを可能にします。この手法は、モデルのパラメータ数を大幅に削減し、効率的な学習を可能にします。

Stable DiffusionとLoRAを組み合わせて使用すると、AIが生成する画像の質や種類を特定のデータセットに適応させ、さらに自身のニーズに合わせてカスタマイズすることが可能になります。

ただし、この技術は一部の高度なユースケースに適用され、日本語や商用利用、拡張機能といった要素とは別に理解し、適用する必要があります。

Stable Diffusionの主な利用方法

Stable Diffusionは多種多様な画像を生成する能力を持つAIモデルを作成することが可能で、以下のような主な利用方法があります。

- 画像生成: ユーザーは指示やキーワード(プロンプト)をAIに提供することで、特定のテーマや要素を含む新たな画像を生成させることができます。この機能はデザイン作業やアートの創作等に有効です。

- AIとの対話: ユーザーはAIと対話し、具体的な指示を出すことで、特定の種類の画像を生成させることが可能です。

ただし、商用利用については、ソフトウェアのライセンス条項に従う必要があります。一部のAIモデルやツールは商用利用が許可されていますが、具体的な条件は製品ごとに異なります。そのため、商用利用を考慮している場合は、各製品の利用規約を必ず確認してください。

Webブラウザ上で利用できるStable Diffusionのサービス

Stable Diffusionはオンライン上で利用可能なAIサービスとしても提供されています。特にHugging Faceは、ユーザーがAIモデルを自由に試すことができるプラットフォームとして人気があります。このプラットフォームでは、ユーザーは独自のプロンプトを使用してAIモデルをテストしたり、新しいモデルを学習したりすることができます。

Hugging Faceで利用できるStable Diffusionのモデルチェックポイント

Hugging Faceでは、Stable Diffusionの複数のモデルチェックポイントが公開されています。それぞれ異なる画像サイズや品質、学習データセットなどの特徴があります。以下は、現在利用できるモデルチェックポイントの一覧です。

| モデル名 | 画像サイズ | 品質 | 学習データセット | リンク |

|---|---|---|---|---|

| runwayml/stable-diffusion-v1-5 | 256×256 | 高品質 | ImageNet + COCO + Conceptual Captions + Open Images + YFCC100M | https://huggingface.co/runwayml/stable-diffusion-v1-5 |

| CompVis/stable-diffusion-v1-4 | 256×256 | 高品質 | ImageNet + COCO + Conceptual Captions + Open Images + YFCC100M | https://huggingface.co/CompVis/stable-diffusion-v1-4 |

| CompVis/stable-diffusion-v1-3 | 128×128 | 中品質 | COCO + Conceptual Captions + Open Images + YFCC100M | https://huggingface.co/CompVis/stable-diffusion-v1-3 |

| CompVis/stable-diffusion-v1-2 | 64×64 | 低品質 | COCO + Conceptual Captions + Open Images + YFCC100M | https://huggingface.co/CompVis/stable-diffusion-v1-2 |

| CompVis/stable-diffusion-v1-1 | 32×32 | 低品質 | COCO + Conceptual Captions + Open Images + YFCC100M | https://huggingface.co/CompVis/stable-diffusion-v1-1 |

Hugging FaceでStable Diffusionを試す方法

Hugging Faceでは、Stable Diffusionを試すために必要なコードやパラメータが提供されています。以下は、基本的な使い方の例です。

- Hugging Faceのサイトにアクセスし、ログインまたはサインアップします。

- 利用したいモデルチェックポイントのページに移動します。

- ページの右上にある「Spaces」ボタンをクリックします。

- 「Spaces」ページで、「Try it out」ボタンをクリックします。

- 「Try it out」ページで、画像生成に使用するプロンプトとシードを入力します。

- 「Generate」ボタンをクリックして、画像生成を開始します。

- 生成された画像が表示されるのを待ちます。

- 生成された画像を保存したり、別のプロンプトやシードで再度試したりできます。

Hugging FaceでStable Diffusionを試した例

Hugging FaceでStable Diffusionを試した例をいくつか紹介します。以下の画像は、runwayml/stable-diffusion-v1-5モデルチェックポイントと、様々なプロンプトとシードを使用して生成されたものです。

| プロンプト | シード | 生成画像 |

|---|---|---|

| a painting of a sunset over the ocean | 0 | a painting of a sunset over the ocean |

| a photo of a cute cat wearing a hat | 42 | a photo of a cute cat wearing a hat |

| a logo of a blue bird with the word “Twitter" | 123 | a logo of a blue bird with the word |

以上が、Webブラウザ上で利用できるStable Diffusionのサービスについての紹介でした。Stable Diffusionは、驚くほどリアルな画像をテキストから生成することができるAI技術です。Hugging Faceのプラットフォームを使えば、誰でも簡単にStable Diffusionを試すことができます。ぜひ、自分の好きなプロンプトやシードで画像生成に挑戦してみてください。

Hugging Faceの使い方

Hugging Faceは、AIモデルを簡単に利用できるプラットフォームで、Stable Diffusionもここから利用できます。以下に、Hugging Faceを通じてStable Diffusionを利用する基本的なステップを紹介します。

- アカウント作成:まずはHugging Faceのウェブサイトからアカウントを作成します。

- モデルの選択:次に、Hugging Faceの「Models」ページから「Stable Diffusion」のモデルを選択します。様々なモデルが利用可能で、それぞれ異なる特性や能力を持っています。

- モデルの使用:モデルを選択したら、画面上のインターフェースを通じてモデルを使用できます。具体的な指示を出すことで、特定の種類の画像を生成させることが可能です。

Githubの使い方

Githubは、ソフトウェアの開発やコードの管理を行うためのプラットフォームであり、Stable Diffusionのコードもここから入手できます。以下に、Githubを通じてStable Diffusionを利用する基本的なステップを紹介します。

- アカウント作成:まずはGithubのウェブサイトからアカウントを作成します。

- リポジトリの検索:次に、Githubの「Search」ページから「Stable Diffusion」を検索します。多くの開発者がStable Diffusionに関連するコードを公開しています。

- リポジトリのクローン:適切なリポジトリを見つけたら、"Clone or download"ボタンをクリックしてリポジトリをクローンします。これにより、ローカルのコンピュータにリポジトリのコピーが作成されます。

- コードの実行:リポジトリをクローンしたら、その中にあるコードを実行することでStable Diffusionを使用できます。ただし、このステップはプログラミング経験や環境設定が必要となる場合があります。

Stable Diffusionのプロンプト作成と作成時のポイント

Stable Diffusionではプロンプト(指示文)を用いてAIに特定の画像を生成させることが可能です。ここでは、効果的なプロンプトの作成方法と注意点について説明します。

- 明確性: プロンプトは具体的で明確であるほど、期待する結果を得る可能性が高まります。例えば、「緑色の蛙」と入力するよりも、「大きな緑色の蛙が小さな池で跳ねている」と入力する方が、より具体的な画像を生成させることが可能です。

- クリエイティブな表現: 文字通りの表現だけでなく、抽象的またはクリエイティブな表現も有効です。例えば、「幸せそうな家」や「深淵から登ってくる怪物」などといった表現も可能です。

- 試行錯誤: 理想的な結果を得るためには、プロンプトの微調整や試行錯誤が必要です。一度に完璧な結果を得るのは難しいかもしれませんが、繰り返し試すことで理想的な画像に近づけるでしょう。

Stable Diffusionのプロンプト例

Stable Diffusionでは、具体的なキーワードや抽象的なフレーズをプロンプトとして使用することで、さまざまな種類の画像を生成することが可能です。以下に、いくつかのプロンプトの例を示します。

- 具体的なプロンプト: “An enormous green frog jumping in a small pond"(「小さな池で跳ねている大きな緑色の蛙」)

- 抽象的なプロンプト: “A monster rising from the abyss"(「深淵から上がってくる怪物」)

- クリエイティブな表現を含むプロンプト: “A house that looks happy"(「幸せそうに見える家」)

注意点として、現時点でStable Diffusionは英語のプロンプトに対応しています。しかし、一部の拡張機能により日本語のプロンプトを使用することも可能です。使用可能な言語については、各サービスの仕様をご確認ください。

Stable Diffusionを使ってできること

Stable Diffusionは非常に多機能で、さまざまなタスクに応用することができます。具体的には、以下のようなことが可能です:

- いろんな種類の画像や文章を一気に作れるAI: 画像やテキストを一枚ずつ作るのではなく、多様なデータを一度に作ることができます。 これは、データの分布を学習することで、様々な可能性を表現することができるからです。例えば、顔の画像を生成する場合、髪型や目の色などの特徴を自由に変えることができます。

- 話しながら作った画像や文章を直せるAI: AIと対話しながら、生成したデータを改良することができます。 これは、データの品質を評価することで、ユーザーの要望に合わせてデータを修正することができるからです。例えば、テキストを生成する場合、文法や内容などのフィードバックを与えることで、テキストをより良くすることができます。

Stable Diffusionを構築するための参考資料

Stable Diffusionはテキストから写真のようにリアルな画像を生成することができるAI技術です。この技術を自分で構築してみたいと思ったことはありませんか?この記事では、Stable Diffusionを構築するために必要な参考資料を紹介します。

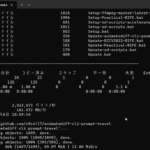

Stable Diffusionの構築に必要なこと

Stable Diffusionを構築するためには、以下のことが必要です。

- Pythonの基本的な知識

- PyTorchなどのライブラリのインストール

- GPU(CPUでも可能)やクラウドサービスなどの高性能な計算環境

- Stable Diffusionのモデルチェックポイントやデータセットなどのダウンロード

これらの準備ができれば、Stable Diffusionを構築することができます。

Stable Diffusionの構築方法を解説した記事と動画

Stable Diffusionの構築方法を詳しく解説した記事や動画があります。以下は、その一部です。

| タイトル | 内容 | リンク |

|---|---|---|

| Stable Diffusionの構築方法 | Stable Diffusion Web UIを実行する方法や、そのために必要なWSL、Dockerの説明。 | https://minokamo.tokyo/2023/07/08/5878/ |

| Stable Diffusion構築動画1 | Stable Diffusion Web UIを実行する方法を動画で解説しています。 | https://youtu.be/R4S19Kx3NcY |

| Stable Diffusion構築動画2 | Stable DiffusionをVirtualBoxで実行する方法を動画で解説しています。 | https://youtu.be/kW931y4mC6I |

Stable Diffusionの構築に成功したら

Stable Diffusionの構築に成功したら、自分の好きなテキストから画像を生成してみましょう。Stable Diffusionは、様々なジャンルやスタイルの画像を生成することができます。例えば、以下のようなテキストから画像を生成することができます。

- アニメ風の女の子のイラスト

- 美味しそうなケーキの写真

- スターウォーズのロゴ

生成した画像は、自分のブログやSNSに投稿したり、友達や家族に見せたりして楽しんでください。また、生成した画像についてフィードバックや感想を動画のコメント欄に残していただけると嬉しいです。動画はこのブログの執筆者が作成しました。

Stable Diffusionの構築に失敗したら

Stable Diffusionの構築に失敗した場合は、落ち込まずに原因を探ってみましょう。以下は、よくある失敗の原因と対処法です。

- 環境やライブラリのバージョンが合わない:環境やライブラリのバージョンを確認して、必要ならアップデートしてください。

- モデルチェックポイントやデータセットのダウンロードができない:ダウンロード先のURLやファイル名が正しいか確認してください。また、インターネット接続が安定しているかも確認してください。

- コードにエラーが発生する:コードにタイプミスや文法ミスがないか確認してください。また、エラーメッセージを読んで、問題箇所を特定してください。

それでも解決しない場合は、質問サイトやコミュニティサイトなどで助けを求めてみましょう。Stable Diffusionに関心のある人々がたくさんいますので、きっと答えが見つかるでしょう。

本記事では、Stable Diffusionを構築するための参考資料を紹介しました。Stable Diffusionは、テキストから写真のようにリアルな画像を生成することができるAI技術です。Hugging FaceやGithubなどのプラットフォームを使えば、自分でStable Diffusionを構築することができます。ぜひ、この記事を参考にして、Stable Diffusionを構築してみてください。Stable Diffusionを使えば、自分の想像力を画像に表現することができます。Stable Diffusionの世界を楽しんでください。

Stable Diffusion利用時の注意点

Stable Diffusionは非常に強力なAI技術ですが、利用時には以下の点に注意する必要があります:

- 著作権:AIが生成する画像は、元の訓練データから影響を受けます。そのため、著作権侵害のリスクがある場合があります。

- エチカルな使用: 一部のユーザーは、偽情報や有害なコンテンツを生成するためにAIを利用する可能性があります。ユーザーは常にエチカルにAIを使用するべきです。

- プライバシー: AIが生成する画像やテキストは、ユーザーの入力やフィードバックに基づいています。そのため、個人情報や機密情報を含むデータをAIに与える場合は、プライバシー保護の観点から注意する必要があります。

Stable Diffusion以外の画像生成AI

Stable Diffusionはただ一つの画像生成AIではありません。他にも、GANs(敵対的生成ネットワーク)やVAEs(変分オートエンコーダ)など、様々な画像生成技術が存在します。それぞれの技術の特徴や違いについて簡単に紹介します。

GANs(敵対的生成ネットワーク)

GANsは、Generator(生成器)とDiscriminator(判別器)という二つのニューラルネットワークを競わせることで、高品質な画像を生成する技術です。Generatorはランダムなノイズから画像を生成し、Discriminatorは画像が本物か偽物かを判別します。GeneratorはDiscriminatorを騙すように学習し、DiscriminatorはGeneratorを見破るように学習します。このようにして、Generatorは本物に近い画像を生成するようになります。GANsの目的関数は以下のように定義されます。

ここで、は本物のデータ(例えば画像)、

はランダムなノイズ、

は本物のデータ分布、

はランダムなノイズ分布、

は

が本物である確率、

は

から生成された偽物のデータ(例えば画像)、

はGANsの目的関数です。

GANsの長所は、高品質で多様な画像を生成できることです。また、目的関数が柔軟であり、様々な分布間の距離や組み合わせを用いることができます。GANsの短所は、学習が不安定であり、勾配消失やモード崩壊といった問題が発生することです。また、生成された画像の尤度を評価することが困難であり、学習の進捗を測ることができません。

VAEs(変分オートエンコーダ)

VAEsは、入力データを潜在変数に変換するEncoder(符号化器)と、潜在変数から出力データを生成するDecoder(復号化器)という二つのニューラルネットワークを用いて、確率的な画像を生成する技術です。Encoderは入力データから潜在変数の平均と分散を推定し、Decoderは潜在変数から出力データを再構成します。EncoderとDecoderは、入力データと出力データの再構成誤差と、潜在変数の事前分布と事後分布のKLダイバージェンスという二つの項からなる目的関数を最小化するように学習します。VAEsの目的関数は以下のように定義されます。

ここで、は入力データ(例えば画像)、

は潜在変数、

はDecoderによる出力データの条件付き分布、

はEncoderによる潜在変数の条件付き分布、

は潜在変数の事前分布(例えば標準正規分布)、

は

と

の間のKLダイバージェンス、

はVAEsの目的関数です。

VAEsの長所は、学習が安定であり、生成された画像の尤度を評価することができることです。また、潜在変数が連続的であり、画像の特徴を操作することができます。VAEsの短所は、生成された画像がぼやけてしまうことです。また、目的関数が限界が適用され、追加のノイズ項が必要になることです。

その他の画像生成技術

GANsとVAEs以外にも、他の画像生成技術があります。例えば、Stable Diffusion以外にもDiffusion Probabilistic ModelsやScore-Based Generative Modelsなどがあります。これらの技術は、画像をノイズに徐々に変換する逆向きの過程を逆転させることで、ノイズから画像を生成する技術です。これらの技術は、GANsやVAEsよりも高品質で多様な画像を生成できることが示されています。

まとめ

このガイドでは、Stable Diffusionについて、その概念、使用方法、利用時の注意点などを詳しく解説しました。この技術は、私たちが画像を生成する方法を根本から変え、新しい可能性を引き出すことができます。しかし、その一方で、エチカルな使用や著作権についても配慮する必要があります。

AIは私たちの生活における強力なツールであり、その可能性は無限大です。しかし、その力を最大限に引き出すためには、適切な知識と理解が必要です。このガイドが、Stable Diffusionという先進的な技術を理解し、自身のプロジェクトに活用する一助となれば幸いです。

最近のコメント